Compare commits

No commits in common. "master" and "bloom-new" have entirely different histories.

2

.gitignore

vendored

@ -5,4 +5,4 @@

|

||||

/.vs

|

||||

/grk/.vs

|

||||

/grk/Debug

|

||||

/grk/planet-editor/Debug

|

||||

/grk/cw 6/Debug

|

||||

0

.vs/CMake Overview

Normal file

3

.vs/ProjectSettings.json

Normal file

@ -0,0 +1,3 @@

|

||||

{

|

||||

"CurrentProjectSetting": "x64-Debug (domyślnie)"

|

||||

}

|

||||

7

.vs/VSWorkspaceState.json

Normal file

@ -0,0 +1,7 @@

|

||||

{

|

||||

"ExpandedNodes": [

|

||||

""

|

||||

],

|

||||

"SelectedNode": "\\grk-cw.sln",

|

||||

"PreviewInSolutionExplorer": false

|

||||

}

|

||||

BIN

.vs/dgrk-2023-planeta/v16/.suo

Normal file

BIN

.vs/slnx.sqlite

Normal file

|

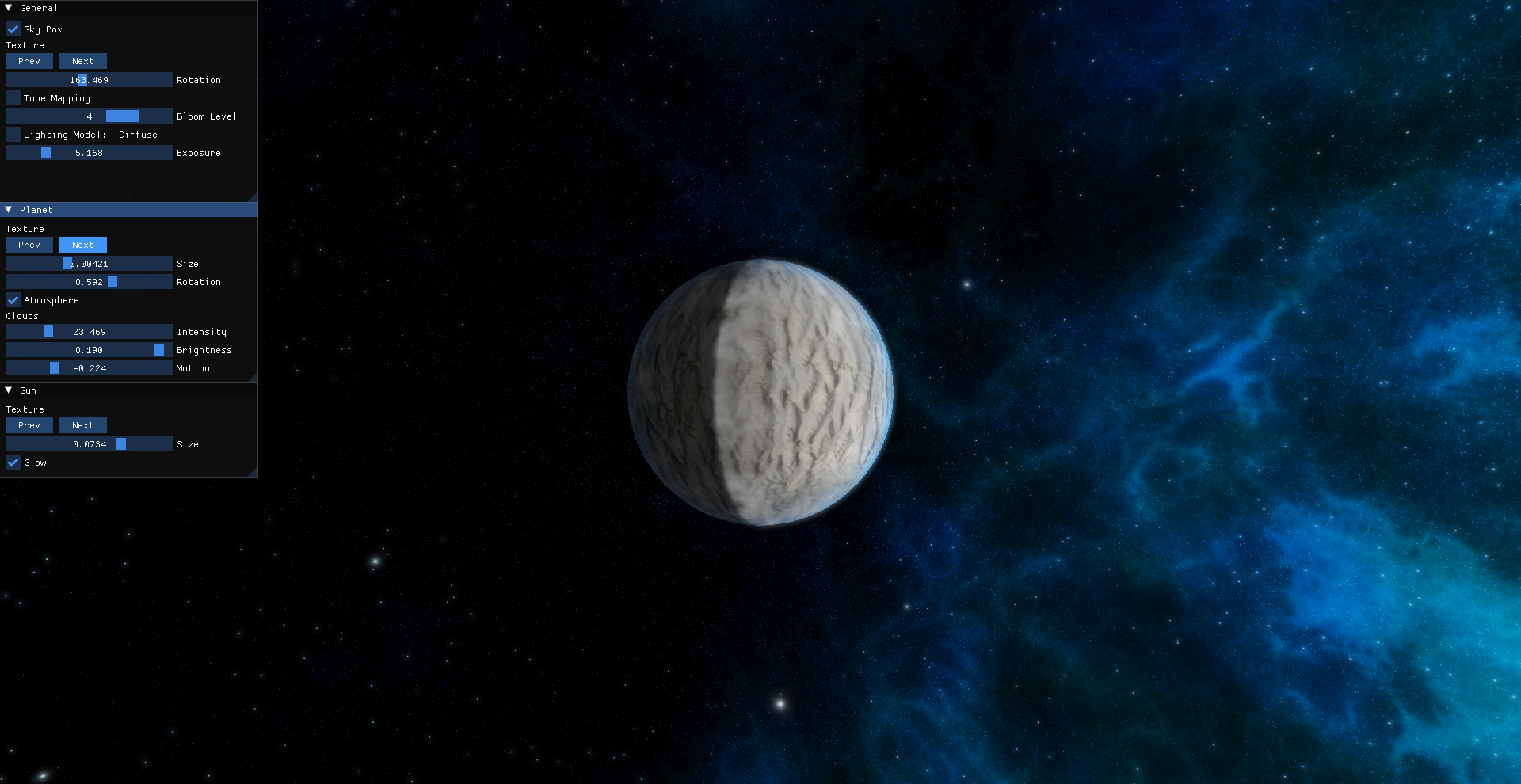

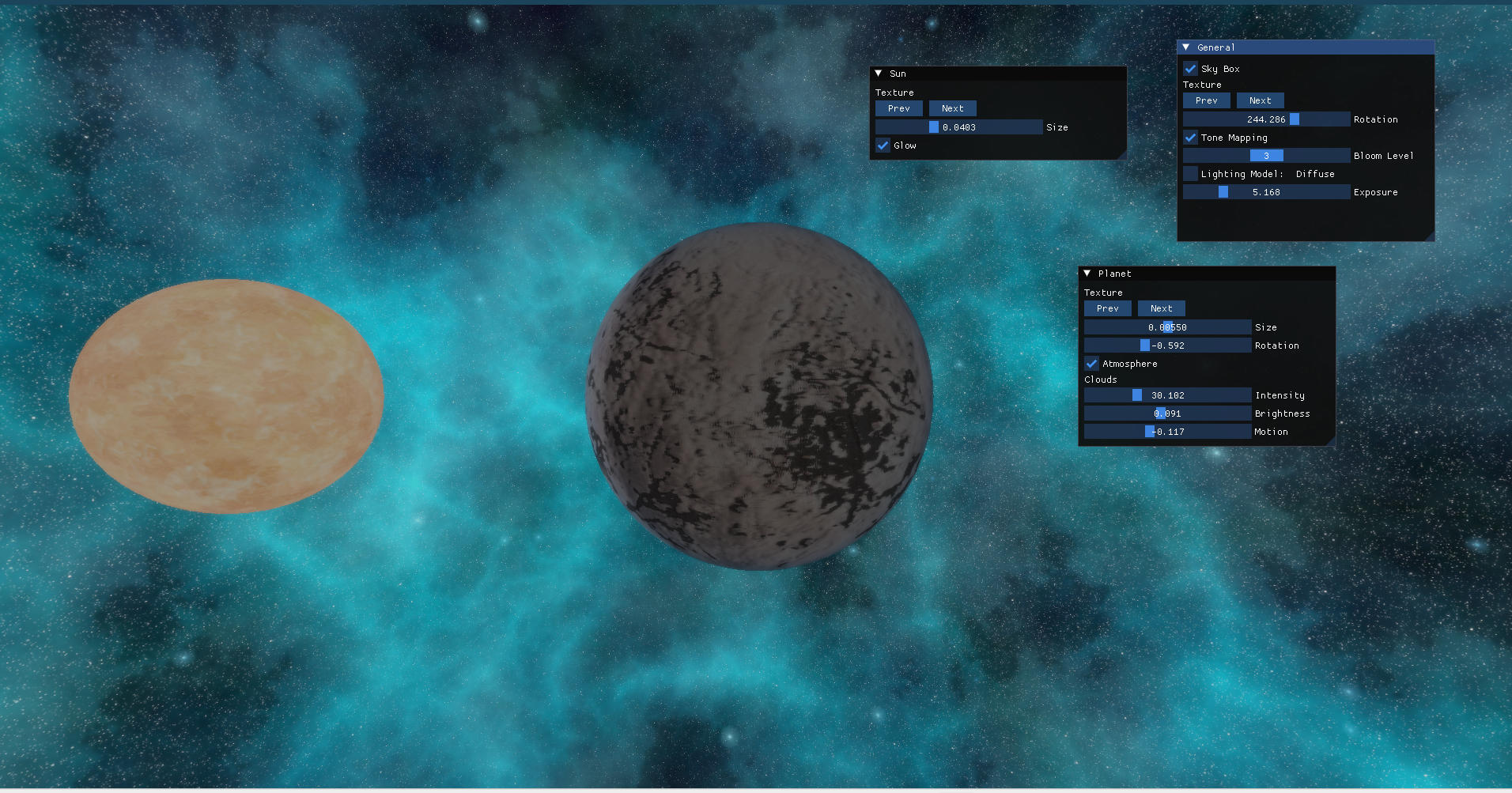

Before

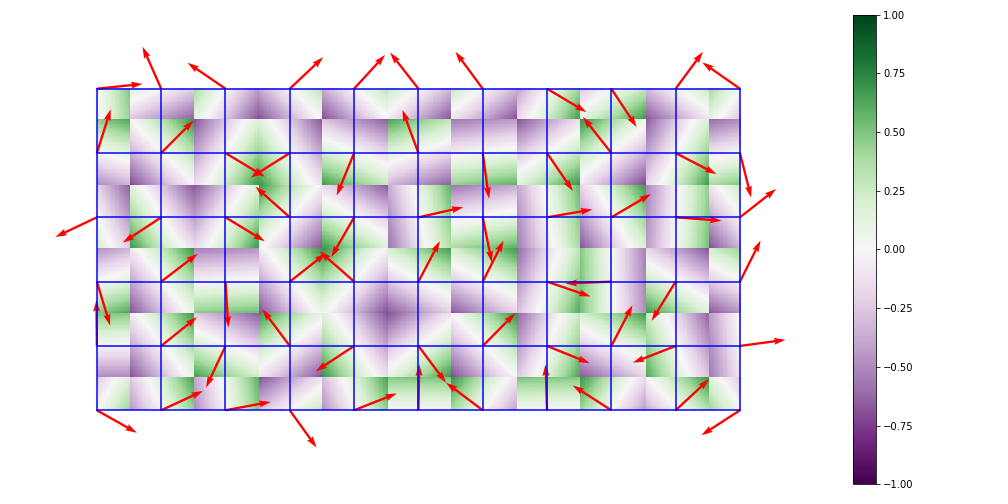

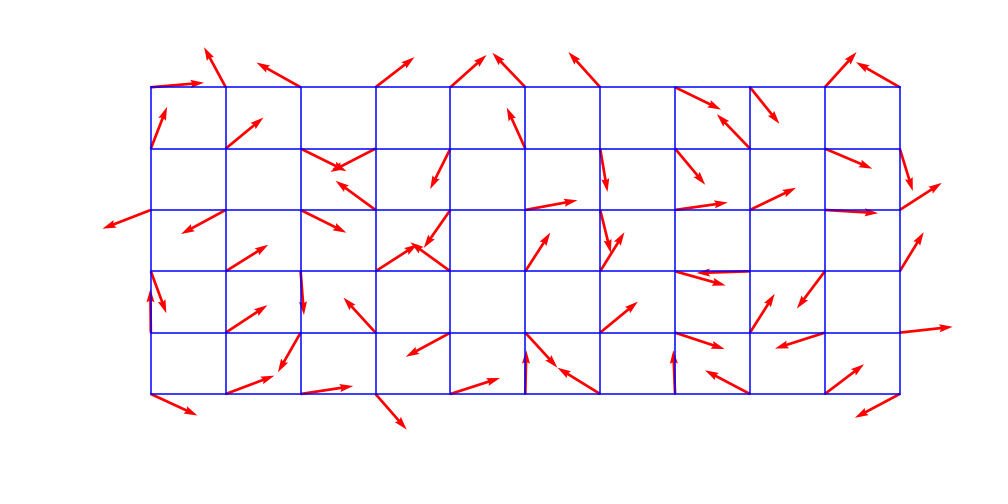

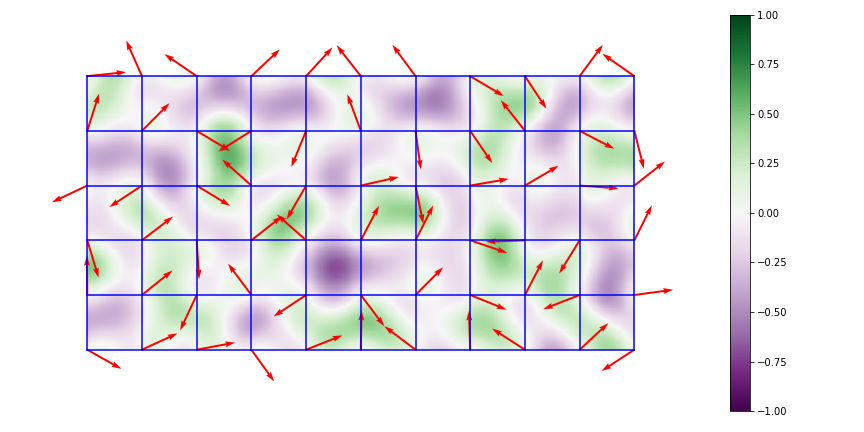

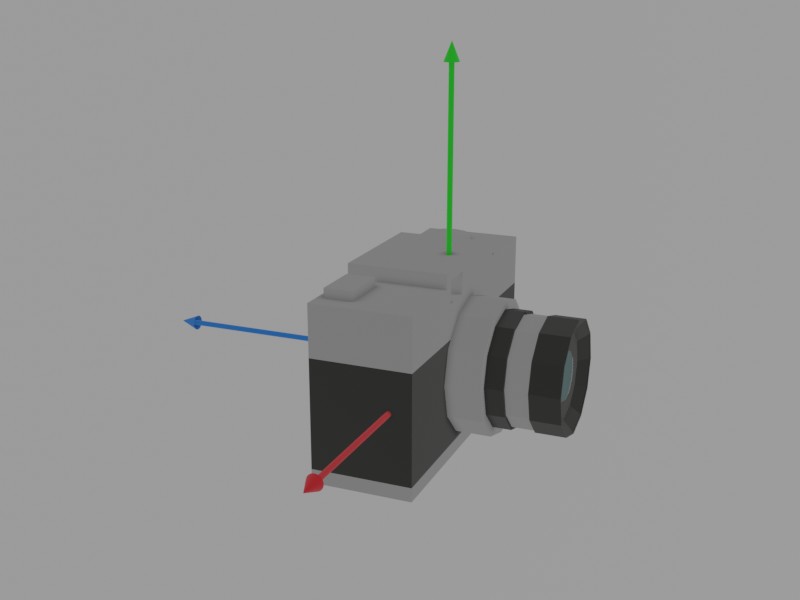

(image error) Size: 2.2 MiB |

|

Before

(image error) Size: 2.7 MiB |

|

Before

(image error) Size: 1.8 MiB |

|

Before

(image error) Size: 1.3 MiB |

144

grk/cw 6/Zadania 2.html

Normal file

@ -0,0 +1,144 @@

|

||||

<!DOCTYPE html>

|

||||

<html xmlns="http://www.w3.org/1999/xhtml" lang="" xml:lang="">

|

||||

<head>

|

||||

<meta charset="utf-8" />

|

||||

<meta name="generator" content="pandoc" />

|

||||

<meta name="viewport" content="width=device-width, initial-scale=1.0, user-scalable=yes" />

|

||||

<title>Zadania 2</title>

|

||||

<style>

|

||||

code{white-space: pre-wrap;}

|

||||

span.smallcaps{font-variant: small-caps;}

|

||||

span.underline{text-decoration: underline;}

|

||||

div.column{display: inline-block; vertical-align: top; width: 50%;}

|

||||

div.hanging-indent{margin-left: 1.5em; text-indent: -1.5em;}

|

||||

ul.task-list{list-style: none;}

|

||||

pre > code.sourceCode { white-space: pre; position: relative; }

|

||||

pre > code.sourceCode > span { display: inline-block; line-height: 1.25; }

|

||||

pre > code.sourceCode > span:empty { height: 1.2em; }

|

||||

code.sourceCode > span { color: inherit; text-decoration: inherit; }

|

||||

div.sourceCode { margin: 1em 0; }

|

||||

pre.sourceCode { margin: 0; }

|

||||

@media screen {

|

||||

div.sourceCode { overflow: auto; }

|

||||

}

|

||||

@media print {

|

||||

pre > code.sourceCode { white-space: pre-wrap; }

|

||||

pre > code.sourceCode > span { text-indent: -5em; padding-left: 5em; }

|

||||

}

|

||||

pre.numberSource code

|

||||

{ counter-reset: source-line 0; }

|

||||

pre.numberSource code > span

|

||||

{ position: relative; left: -4em; counter-increment: source-line; }

|

||||

pre.numberSource code > span > a:first-child::before

|

||||

{ content: counter(source-line);

|

||||

position: relative; left: -1em; text-align: right; vertical-align: baseline;

|

||||

border: none; display: inline-block;

|

||||

-webkit-touch-callout: none; -webkit-user-select: none;

|

||||

-khtml-user-select: none; -moz-user-select: none;

|

||||

-ms-user-select: none; user-select: none;

|

||||

padding: 0 4px; width: 4em;

|

||||

color: #aaaaaa;

|

||||

}

|

||||

pre.numberSource { margin-left: 3em; border-left: 1px solid #aaaaaa; padding-left: 4px; }

|

||||

div.sourceCode

|

||||

{ }

|

||||

@media screen {

|

||||

pre > code.sourceCode > span > a:first-child::before { text-decoration: underline; }

|

||||

}

|

||||

code span.al { color: #ff0000; font-weight: bold; } /* Alert */

|

||||

code span.an { color: #60a0b0; font-weight: bold; font-style: italic; } /* Annotation */

|

||||

code span.at { color: #7d9029; } /* Attribute */

|

||||

code span.bn { color: #40a070; } /* BaseN */

|

||||

code span.bu { } /* BuiltIn */

|

||||

code span.cf { color: #007020; font-weight: bold; } /* ControlFlow */

|

||||

code span.ch { color: #4070a0; } /* Char */

|

||||

code span.cn { color: #880000; } /* Constant */

|

||||

code span.co { color: #60a0b0; font-style: italic; } /* Comment */

|

||||

code span.cv { color: #60a0b0; font-weight: bold; font-style: italic; } /* CommentVar */

|

||||

code span.do { color: #ba2121; font-style: italic; } /* Documentation */

|

||||

code span.dt { color: #902000; } /* DataType */

|

||||

code span.dv { color: #40a070; } /* DecVal */

|

||||

code span.er { color: #ff0000; font-weight: bold; } /* Error */

|

||||

code span.ex { } /* Extension */

|

||||

code span.fl { color: #40a070; } /* Float */

|

||||

code span.fu { color: #06287e; } /* Function */

|

||||

code span.im { } /* Import */

|

||||

code span.in { color: #60a0b0; font-weight: bold; font-style: italic; } /* Information */

|

||||

code span.kw { color: #007020; font-weight: bold; } /* Keyword */

|

||||

code span.op { color: #666666; } /* Operator */

|

||||

code span.ot { color: #007020; } /* Other */

|

||||

code span.pp { color: #bc7a00; } /* Preprocessor */

|

||||

code span.sc { color: #4070a0; } /* SpecialChar */

|

||||

code span.ss { color: #bb6688; } /* SpecialString */

|

||||

code span.st { color: #4070a0; } /* String */

|

||||

code span.va { color: #19177c; } /* Variable */

|

||||

code span.vs { color: #4070a0; } /* VerbatimString */

|

||||

code span.wa { color: #60a0b0; font-weight: bold; font-style: italic; } /* Warning */

|

||||

</style>

|

||||

<link rel="stylesheet" href="style.css" />

|

||||

<!--[if lt IE 9]>

|

||||

<script src="//cdnjs.cloudflare.com/ajax/libs/html5shiv/3.7.3/html5shiv-printshiv.min.js"></script>

|

||||

<![endif]-->

|

||||

</head>

|

||||

<body>

|

||||

<h2 id="ładowanie-vao-i-vbo">Ładowanie VAO i VBO</h2>

|

||||

<p>W trakcie tych zajęć przećwiczymy ładowanie danych do pamięci. Tym razem, zamiast korzystać z gotowej funkcji utworzymy je samodzielnie. W openglu wykorzystujemy do tego VBO (Vertex Buffer Object) i VAO (Vertex Array Object). Pierwsza jest buforem, który zawiera dane modeli. Natomiast drugi zawiera informacje jak dane bufory interpretować.</p>

|

||||

<p>W zadaniu <code>2_1</code> będziemy przesyłać prostopadłościan. Tablica zawierająca jego definicję jest w pliku <code>Box.cpp</code>. Każdy wierzchołek składa się z ośmiu floatów, pierwsze cztery określają jego pozycję, a cztery kolejny określają jego kolor.</p>

|

||||

<p>Inicjalizacje będziemy wykonywać wewnątrz funkcji <code>init</code>. Pierwszym krokiem jest wygenerowanie jednego VAO i jednego VBO. Wykorzystuje się do tego odpowiednio funkcje <code>glGenVertexArrays</code> i <code>glGenBuffers</code>. Pierwszym argumentem jest liczba buforów czy array object, które tworzymy, drugim jest adres, w którym ma być bufor/array object umieszczony. W naszym przypadku pierwszym argumentem będzie 1, natomiast drugim będzie wskaźnik na zmienną <code>VAO</code> i <code>VBO</code> odpowiednio. Następnie należy aktywować <code>VAO</code> za pomocą funkcji <code>glBindVertexArray</code>, po czym podpiąć do niego bufor <code>VBO</code> za pomocą <code>glBindBuffer(GLenum target, GLuint buffer)</code> nasz target to <code>GL_ARRAY_BUFFER</code>, czyli bufor, który oznacza atrybuty wierzchołków.</p>

|

||||

<p>Kolejnym krokiem jest umieszczenie danych w buforze za pomocą funkcji <code>glBufferData(GLenum target, GLsizeiptr size, const void * data, GLenum usage)</code>. Pierwszym argumentem jest ponownie <code>GL_ARRAY_BUFFER</code>, drugi to rozmiar tablicy w bajtach, trzecim adres tablicy, a czwartym sposób używania tablicy, w naszym przypadku <code>GL_STATIC_DRAW</code>.</p>

|

||||

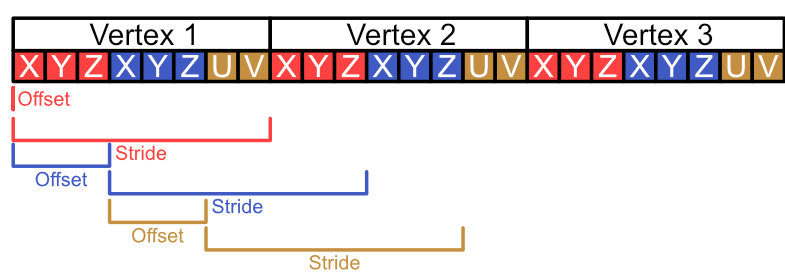

<p>Pozostaje opisanie atrybutów wierzchołków, musimy opisać, gdzie się znajdują, jaką mają strukturę i jak ma się do nich odnieść shader. My mamy 2 atrybuty, jest to pozycja i kolor. Pierwszym krokiem jest aktywacja atrybutów za pomocą <code>glEnableVertexAttribArray(GLuint index)</code>, przy czym po indeksie będą one odnajdywane przez shader. W naszym przypadku będą to odpowiednio 0 i 1. Następnie należy opisać jak GPU ma odczytywać atrybuty z bufora za pomocą funkcji <code>glVertexAttribPointer( GLuint index, GLint size, GLenum type, GLboolean normalized, GLsizei stride, const void * offset)</code>. Jej argumenty to kolejno: * <code>index</code> - indeksy odpowiadające atrybutowi, * <code>size</code> - liczba elementów w atrybucie wierzchołka, może wynosić 1, 2, 3 lub 4, * <code>type</code> - typ danych jako enum, w naszym przypadku <code>GL_FLOAT</code>, * <code>normalized</code> - określa czy wartość ma być znormalizowana, u nas będzie to <code>GL_FALSE</code>, * <code>stride</code> - określa dystans pomiędzy atrybutami w kolejnych wierzchołkach * <code>offset</code> - wskaźnik na pierwszy atrybut w tablicy, licząc względem początku tablicy i typu (void *)</p>

|

||||

<p>Struktura naszego prostopadłościanu ma na przemian pozycje i kolory, dlatego w obu przypadkach stride będzie wynosił ośmiokrotność rozmiaru <em>floata</em>. Natomiast <em>offest</em> będzie wynosił zero i czterokrotność rozmiaru <em>floata</em>.</p>

|

||||

<p><img src="./img/stride_offest.jpg" /></p>

|

||||

<p>Na koniec uwolnij <code>VAO</code> za pomocą instrukcji: <code>glBindVertexArray(0);</code>.</p>

|

||||

<p>Pozostaje narysować prostopadłościan. W funkcji <code>renderScene</code> wywołaj <code>glBindVertexArray</code> z argumentem <code>VAO</code>. Następnie narysuj za pomocą <code>glDrawArrays(GLenum mode, GLint first, GLsizei count)</code>. Pierwszym argumentem jest typ rysowanego obiektu, w naszym przypadku jest to <code>GL_TRIANGLES</code>, indeks pierwszego wierzchołka, czyli 0 i liczba wierzchołków czyli 36.</p>

|

||||

<h3 id="zadanie">Zadanie</h3>

|

||||

<p>podążając za powyższymi instrukcjami zainicjalizuj box, następnie obróć go za pomocą funkcji <code>glm::eulerAngleXYZ</code> tak, żeby było widać trzy ściany prostopadłościany. Dodaj również obrót wokół osi Y w czasie z użyciem funkcji <code>glm::eulerAngleXYZ</code>.</p>

|

||||

<h3 id="zadanie-1">Zadanie*</h3>

|

||||

<p>Wykonaj zadania z <code>ex_2_1b.hpp</code>.</p>

|

||||

<h2 id="shadery">Shadery</h2>

|

||||

<p>Shadery są programami uruchamianymi na karcie graficznej. W openglu wykorzystujemy język GLSL, który jest bardzo podobny do C++, posiada on liczne słowa kluczowe i funkcje matematyczne. Istnieją różne rodzaje shaderów, w tej sekcji skupimy się na dwóch z nich: shader wierzchołków i shader fragmentów. Pierwszy rodzaj wykonują operacje na wierzchołkach, przykładowo w tym zadaniu odpowiada za przemnożenie macierzy obrotu przez wierzchołki. Natomiast drugi określa kolor konkretnego fragmentu/piksela. Shadery są łączone w <em>pipeline</em>, to znaczy wykonuje się je sekwencyjnie, dane z poprzedniego są wysyłane do następnego. W zadaniu <code>2_1</code> wykorzystujemy następujące shadery</p>

|

||||

<p>shader wierzchołków</p>

|

||||

<div class="sourceCode" id="cb1"><pre class="sourceCode glsl"><code class="sourceCode glsl"><span id="cb1-1"><a href="#cb1-1" aria-hidden="true" tabindex="-1"></a><span class="pp">#version 430 core</span></span>

|

||||

<span id="cb1-2"><a href="#cb1-2" aria-hidden="true" tabindex="-1"></a></span>

|

||||

<span id="cb1-3"><a href="#cb1-3" aria-hidden="true" tabindex="-1"></a><span class="kw">layout</span>(<span class="dt">location</span> = <span class="dv">0</span>) <span class="dt">in</span> <span class="dt">vec4</span> vertexPosition;</span>

|

||||

<span id="cb1-4"><a href="#cb1-4" aria-hidden="true" tabindex="-1"></a><span class="kw">layout</span>(<span class="dt">location</span> = <span class="dv">1</span>) <span class="dt">in</span> <span class="dt">vec4</span> vertexColor;</span>

|

||||

<span id="cb1-5"><a href="#cb1-5" aria-hidden="true" tabindex="-1"></a></span>

|

||||

<span id="cb1-6"><a href="#cb1-6" aria-hidden="true" tabindex="-1"></a><span class="kw">uniform</span> <span class="dt">mat4</span> transformation;</span>

|

||||

<span id="cb1-7"><a href="#cb1-7" aria-hidden="true" tabindex="-1"></a></span>

|

||||

<span id="cb1-8"><a href="#cb1-8" aria-hidden="true" tabindex="-1"></a></span>

|

||||

<span id="cb1-9"><a href="#cb1-9" aria-hidden="true" tabindex="-1"></a><span class="dt">void</span> <span class="fu">main</span>()</span>

|

||||

<span id="cb1-10"><a href="#cb1-10" aria-hidden="true" tabindex="-1"></a>{</span>

|

||||

<span id="cb1-11"><a href="#cb1-11" aria-hidden="true" tabindex="-1"></a> <span class="bu">gl_Position</span> = transformation * vertexPosition;</span>

|

||||

<span id="cb1-12"><a href="#cb1-12" aria-hidden="true" tabindex="-1"></a>}</span></code></pre></div>

|

||||

<p>shader fragmentów</p>

|

||||

<div class="sourceCode" id="cb2"><pre class="sourceCode glsl"><code class="sourceCode glsl"><span id="cb2-1"><a href="#cb2-1" aria-hidden="true" tabindex="-1"></a><span class="pp">#version 430 core</span></span>

|

||||

<span id="cb2-2"><a href="#cb2-2" aria-hidden="true" tabindex="-1"></a></span>

|

||||

<span id="cb2-3"><a href="#cb2-3" aria-hidden="true" tabindex="-1"></a></span>

|

||||

<span id="cb2-4"><a href="#cb2-4" aria-hidden="true" tabindex="-1"></a><span class="dt">out</span> <span class="dt">vec4</span> out_color;</span>

|

||||

<span id="cb2-5"><a href="#cb2-5" aria-hidden="true" tabindex="-1"></a><span class="dt">void</span> <span class="fu">main</span>()</span>

|

||||

<span id="cb2-6"><a href="#cb2-6" aria-hidden="true" tabindex="-1"></a>{</span>

|

||||

<span id="cb2-7"><a href="#cb2-7" aria-hidden="true" tabindex="-1"></a> out_color = <span class="dt">vec4</span>(<span class="fl">0.8</span>,<span class="fl">0.2</span>,<span class="fl">0.9</span>,<span class="fl">1.0</span>);</span>

|

||||

<span id="cb2-8"><a href="#cb2-8" aria-hidden="true" tabindex="-1"></a>}</span></code></pre></div>

|

||||

<p>Shader wierzchołków odbiera 2 typy danych. Pierwszym są dane z bufora w liniach.</p>

|

||||

<pre><code>layout(location = 0) in vec4 vertexPosition;

|

||||

layout(location = 1) in vec4 vertexColor;</code></pre>

|

||||

<p>są one różne dla każdego wierzchołka. Zmienną, która ma odebrać te dane deklaruje się globalnie funkcją <code>main</code> i poprzedza się słowem kluczowym <code>in</code>. Prefiks <code>layout(location = ..)</code> jest opcjonalny i służy określeniu indeksu atrybutu, jest to ta sama wartość, którą ustawiliśmy w <code>glVertexAttribPointer</code>. Można je usunąć, wtedy o indeksie będzie decydować kolejność. Drugim typem jest <code>uniform</code>, w przeciwieństwie do danych z bufora, są one takie same dla każdego wierzchołka. W tym przypadku przesyłamy za jej pomocą macierz obrotu.</p>

|

||||

<p>Shader również wysyła dane. Domyślnie musi wysłać wyjściową pozycję wierzchołka, robi to przez zapisanie w <code>gl_Position</code> wektora 4-wymiarowego w funkcji <code>main</code>. Poza tym może również przesłać inne informacje. Wykonuje się to przez deklaracje zmiennej globalnej, którą poprzedza się słowem kluczowym <code>out</code>. Następnie należy ją wypełnić. W tym przypadku przesyłamy kolor wierzchołka.</p>

|

||||

<p>Shader fragmentów odbiera kolor z Shadera wierzchołków. Podobnie jak z obieraniem danych z buforu robimy to za pomocą słowa kluczowego <code>in</code>, w przypadku przesyłania zmiennej z jednego shadera do drugiego nazwy zmiennych muszą być <strong>takie same</strong> przy słowie kluczowym <code>out</code> i <code>in</code>. Zmiennej obranej nie można modyfikować.</p>

|

||||

<p>W najnowszej wersji opengla fragment shader nie ma domyślnego wyjścia na kolor, musimy sami je z definiować. Robimy to instrukcją <code>out vec4 out_color</code> następnie w funkcji <code>main</code> przypisujemy mu jakąś wartość.</p>

|

||||

<h3 id="zadanie-2">Zadanie</h3>

|

||||

<p>W tej chwili nasz prostopadłościan jest jednolitego koloru i nie możemy rozróżnić jego ścian. Przesłana przez nas wcześniej informacja o kolorze nie została wykorzystana. Bazując na powyższych informacjach prześlij wartość koloru zapisaną w <code>vertexColor</code> do shadera fragmentu i przypisz ją do wyjściowego koloru. Dodaj zmienną <code>in vec4 color</code> w shaderze fragmentów, następnie w funkcji <code>main</code> przypisz do niej wartość koloru. W shaderze fragmentów odbierz ją za pomocą <code>out</code> i przypisz do wyjściowego koloru.</p>

|

||||

<p>Zauważ, że kolor ścian nie jest jednolity, zamiast tego przechodzą gradientem od jednego koloru do drugiego. Dzieje się tak, ponieważ na etapie rasteryzacji kolor jest interpolowany. To znaczy: wartość jest uśredniana pomiędzy wierzchołkami trójkąta.</p>

|

||||

<h3 id="zadanie-3">Zadanie</h3>

|

||||

<p>Sprawdź, jak będzie wyglądać prostopadłościan z wyłączoną interpolacją. Dodaj przed <code>in</code> i <code>out</code> <code>color</code> słowo kluczowe <code>flat</code>.</p>

|

||||

<h3 id="zadanie-4">Zadanie</h3>

|

||||

<p>Prześlij czas od startu aplikacji do shadera fragmentów. Użyj funkcji <code>glfwGetTime</code>, by uzyskać czas. Utwórz zmienną <code>uniform</code> typu <code>float</code> we shaderze fragmentów. Następnie prześlij do niej wynik funkcji <code>glfwGetTime</code>. Aby przesłać czas do shadera, wykorzystaj funkcje <code>glUniform1f</code>. Pierwszym argumentem jest lokacja uniforma, drugim przypisywana wartość. Lokację uzyskamy za pomocą funckji <code>glGetUniformLocation(progam,"time")</code> pierwszym argumentem jest program, którego używamy a drugim nazwa zmiennej uniform. Podziel kolor przez czas, by uzyskać efekt, w którym prostopadłościan robi się czarny.</p>

|

||||

<h3 id="zadanie-5">Zadanie*</h3>

|

||||

<p>Wykorzystaj przesłany czas, żeby sprawić, żeby prostopadłościan znikał przez mieszanie go z kolorem tła. Wykorzystaj do tego następujące funkcje GLSL: <code>mix</code>, <code>sin</code>, <code>vec4</code>. Opis ich działania możesz znaleźć w dokumentacji https://docs.gl/.</p>

|

||||

<h3 id="zadanie-6">Zadanie</h3>

|

||||

<p>Prześlij pozycję lokalną i globalną pozycję wierzchołków do shadera fragmentów i wyświetl ją.</p>

|

||||

<p>W shaderze wierzchołków obok deklaracji <code>out vec4 color;</code> dodaj analogiczne o nazwie <code>pos_local</code> i <code>pos_global</code>. Do <code>pos_local</code> przypisz <code>vertexPosition</code>, a do <code>pos_global</code> przypisz <code>transformation * vertexPosition</code>. Podobnie dopisz odebranie ich w shaderze fragmentów. Użyj <code>pos_local</code>, następnie <code>pos_global</code> jako zamiast koloru. Dlaczego otrzymaliśmy taki efekt?</p>

|

||||

<h3 id="zadanie-7">Zadanie*</h3>

|

||||

<p>Użyj jednej ze zmiennych z poprzedniego zadania do zrobienia pasków na przynajmniej jednej ze ścian sześcianu. Wykorzystaj czas, żeby paski się przesuwały.</p>

|

||||

</body>

|

||||

</html>

|

||||

105

grk/cw 6/Zadania 2.md

Normal file

@ -0,0 +1,105 @@

|

||||

## Ładowanie VAO i VBO

|

||||

|

||||

W trakcie tych zajęć przećwiczymy ładowanie danych do pamięci. Tym razem, zamiast korzystać z gotowej funkcji utworzymy je samodzielnie. W openglu wykorzystujemy do tego VBO (Vertex Buffer Object) i VAO (Vertex Array Object). Pierwsza jest buforem, który zawiera dane modeli. Natomiast drugi zawiera informacje jak dane bufory interpretować.

|

||||

|

||||

W zadaniu `2_1` będziemy przesyłać prostopadłościan. Tablica zawierająca jego definicję jest w pliku `Box.cpp`. Każdy wierzchołek składa się z ośmiu floatów, pierwsze cztery określają jego pozycję, a cztery kolejny określają jego kolor.

|

||||

|

||||

Inicjalizacje będziemy wykonywać wewnątrz funkcji `init`. Pierwszym krokiem jest wygenerowanie jednego VAO i jednego VBO. Wykorzystuje się do tego odpowiednio funkcje `glGenVertexArrays` i `glGenBuffers`. Pierwszym argumentem jest liczba buforów czy array object, które tworzymy, drugim jest adres, w którym ma być bufor/array object umieszczony.

|

||||

W naszym przypadku pierwszym argumentem będzie 1, natomiast drugim będzie wskaźnik na zmienną `VAO` i `VBO` odpowiednio. Następnie należy aktywować `VAO` za pomocą funkcji `glBindVertexArray`, po czym podpiąć do niego bufor `VBO` za pomocą `glBindBuffer(GLenum target, GLuint buffer)` nasz target to `GL_ARRAY_BUFFER`, czyli bufor, który oznacza atrybuty wierzchołków.

|

||||

|

||||

Kolejnym krokiem jest umieszczenie danych w buforze za pomocą funkcji `glBufferData(GLenum target, GLsizeiptr size, const void * data, GLenum usage)`. Pierwszym argumentem jest ponownie `GL_ARRAY_BUFFER`, drugi to rozmiar tablicy w bajtach, trzecim adres tablicy, a czwartym sposób używania tablicy, w naszym przypadku `GL_STATIC_DRAW`.

|

||||

|

||||

Pozostaje opisanie atrybutów wierzchołków, musimy opisać, gdzie się znajdują, jaką mają strukturę i jak ma się do nich odnieść shader. My mamy 2 atrybuty, jest to pozycja i kolor. Pierwszym krokiem jest aktywacja atrybutów za pomocą `glEnableVertexAttribArray(GLuint index)`, przy czym po indeksie będą one odnajdywane przez shader. W naszym przypadku będą to odpowiednio 0 i 1. Następnie należy opisać jak GPU ma odczytywać atrybuty z bufora za pomocą funkcji `glVertexAttribPointer( GLuint index, GLint size, GLenum type, GLboolean normalized, GLsizei stride, const void * offset)`. Jej argumenty to kolejno:

|

||||

* `index` - indeksy odpowiadające atrybutowi,

|

||||

* `size` - liczba elementów w atrybucie wierzchołka, może wynosić 1, 2, 3 lub 4,

|

||||

* `type` - typ danych jako enum, w naszym przypadku `GL_FLOAT`,

|

||||

* `normalized` - określa czy wartość ma być znormalizowana, u nas będzie to `GL_FALSE`,

|

||||

* `stride` - określa dystans pomiędzy atrybutami w kolejnych wierzchołkach

|

||||

* `offset` - wskaźnik na pierwszy atrybut w tablicy, licząc względem początku tablicy i typu (void \*)

|

||||

|

||||

Struktura naszego prostopadłościanu ma na przemian pozycje i kolory, dlatego w obu przypadkach stride będzie wynosił ośmiokrotność rozmiaru *floata*. Natomiast *offest* będzie wynosił zero i czterokrotność rozmiaru *floata*.

|

||||

|

||||

|

||||

|

||||

Na koniec uwolnij `VAO` za pomocą instrukcji: `glBindVertexArray(0);`.

|

||||

|

||||

Pozostaje narysować prostopadłościan. W funkcji `renderScene` wywołaj `glBindVertexArray` z argumentem `VAO`. Następnie narysuj za pomocą `glDrawArrays(GLenum mode, GLint first, GLsizei count)`. Pierwszym argumentem jest typ rysowanego obiektu, w naszym przypadku jest to `GL_TRIANGLES`, indeks pierwszego wierzchołka, czyli 0 i liczba wierzchołków czyli 36.

|

||||

|

||||

### Zadanie

|

||||

podążając za powyższymi instrukcjami zainicjalizuj box, następnie obróć go za pomocą funkcji `glm::eulerAngleXYZ` tak, żeby było widać trzy ściany prostopadłościany. Dodaj również obrót wokół osi Y w czasie z użyciem funkcji `glm::eulerAngleXYZ`.

|

||||

|

||||

### Zadanie*

|

||||

Wykonaj zadania z `ex_2_1b.hpp`.

|

||||

|

||||

|

||||

## Shadery

|

||||

|

||||

Shadery są programami uruchamianymi na karcie graficznej. W openglu wykorzystujemy język GLSL, który jest bardzo podobny do C++, posiada on liczne słowa kluczowe i funkcje matematyczne. Istnieją różne rodzaje shaderów, w tej sekcji skupimy się na dwóch z nich: shader wierzchołków i shader fragmentów. Pierwszy rodzaj wykonują operacje na wierzchołkach, przykładowo w tym zadaniu odpowiada za przemnożenie macierzy obrotu przez wierzchołki. Natomiast drugi określa kolor konkretnego fragmentu/piksela. Shadery są łączone w *pipeline*, to znaczy wykonuje się je sekwencyjnie, dane z poprzedniego są wysyłane do następnego.

|

||||

W zadaniu `2_1` wykorzystujemy następujące shadery

|

||||

|

||||

shader wierzchołków

|

||||

```GLSL

|

||||

#version 430 core

|

||||

|

||||

layout(location = 0) in vec4 vertexPosition;

|

||||

layout(location = 1) in vec4 vertexColor;

|

||||

|

||||

uniform mat4 transformation;

|

||||

|

||||

|

||||

void main()

|

||||

{

|

||||

gl_Position = transformation * vertexPosition;

|

||||

}

|

||||

```

|

||||

|

||||

shader fragmentów

|

||||

```GLSL

|

||||

#version 430 core

|

||||

|

||||

|

||||

out vec4 out_color;

|

||||

void main()

|

||||

{

|

||||

out_color = vec4(0.8,0.2,0.9,1.0);

|

||||

}

|

||||

```

|

||||

|

||||

Shader wierzchołków odbiera 2 typy danych. Pierwszym są dane z bufora w liniach.

|

||||

```

|

||||

layout(location = 0) in vec4 vertexPosition;

|

||||

layout(location = 1) in vec4 vertexColor;

|

||||

```

|

||||

są one różne dla każdego wierzchołka. Zmienną, która ma odebrać te dane deklaruje się globalnie funkcją `main` i poprzedza się słowem kluczowym `in`. Prefiks `layout(location = ..)` jest opcjonalny i służy określeniu indeksu atrybutu, jest to ta sama wartość, którą ustawiliśmy w `glVertexAttribPointer`. Można je usunąć, wtedy o indeksie będzie decydować kolejność.

|

||||

Drugim typem jest `uniform`, w przeciwieństwie do danych z bufora, są one takie same dla każdego wierzchołka. W tym przypadku przesyłamy za jej pomocą macierz obrotu.

|

||||

|

||||

Shader również wysyła dane. Domyślnie musi wysłać wyjściową pozycję wierzchołka, robi to przez zapisanie w `gl_Position` wektora 4-wymiarowego w funkcji `main`. Poza tym może również przesłać inne informacje. Wykonuje się to przez deklaracje zmiennej globalnej, którą poprzedza się słowem kluczowym `out`. Następnie należy ją wypełnić. W tym przypadku przesyłamy kolor wierzchołka.

|

||||

|

||||

Shader fragmentów odbiera kolor z Shadera wierzchołków. Podobnie jak z obieraniem danych z buforu robimy to za pomocą słowa kluczowego `in`, w przypadku przesyłania zmiennej z jednego shadera do drugiego nazwy zmiennych muszą być **takie same** przy słowie kluczowym `out` i `in`. Zmiennej obranej nie można modyfikować.

|

||||

|

||||

W najnowszej wersji opengla fragment shader nie ma domyślnego wyjścia na kolor, musimy sami je z definiować. Robimy to instrukcją `out vec4 out_color` następnie w funkcji `main` przypisujemy mu jakąś wartość.

|

||||

|

||||

### Zadanie

|

||||

W tej chwili nasz prostopadłościan jest jednolitego koloru i nie możemy rozróżnić jego ścian. Przesłana przez nas wcześniej informacja o kolorze nie została wykorzystana. Bazując na powyższych informacjach prześlij wartość koloru zapisaną w `vertexColor` do shadera fragmentu i przypisz ją do wyjściowego koloru. Dodaj zmienną `in vec4 color` w shaderze fragmentów, następnie w funkcji `main` przypisz do niej wartość koloru. W shaderze fragmentów odbierz ją za pomocą `out` i przypisz do wyjściowego koloru.

|

||||

|

||||

Zauważ, że kolor ścian nie jest jednolity, zamiast tego przechodzą gradientem od jednego koloru do drugiego. Dzieje się tak, ponieważ na etapie rasteryzacji kolor jest interpolowany. To znaczy: wartość jest uśredniana pomiędzy wierzchołkami trójkąta.

|

||||

|

||||

### Zadanie

|

||||

Sprawdź, jak będzie wyglądać prostopadłościan z wyłączoną interpolacją. Dodaj przed `in` i `out` ` color` słowo kluczowe `flat`.

|

||||

|

||||

### Zadanie

|

||||

Prześlij czas od startu aplikacji do shadera fragmentów. Użyj funkcji `glfwGetTime`, by uzyskać czas. Utwórz zmienną `uniform` typu `float` we shaderze fragmentów. Następnie prześlij do niej wynik funkcji `glfwGetTime`. Aby przesłać czas do shadera, wykorzystaj funkcje `glUniform1f`. Pierwszym argumentem jest lokacja uniforma, drugim przypisywana wartość. Lokację uzyskamy za pomocą funckji `glGetUniformLocation(progam,"time")` pierwszym argumentem jest program, którego używamy a drugim nazwa zmiennej uniform.

|

||||

Podziel kolor przez czas, by uzyskać efekt, w którym prostopadłościan robi się czarny.

|

||||

|

||||

### Zadanie*

|

||||

Wykorzystaj przesłany czas, żeby sprawić, żeby prostopadłościan znikał przez mieszanie go z kolorem tła. Wykorzystaj do tego następujące funkcje GLSL: `mix`, `sin`, `vec4`. Opis ich działania możesz znaleźć w dokumentacji https://docs.gl/.

|

||||

|

||||

### Zadanie

|

||||

|

||||

Prześlij pozycję lokalną i globalną pozycję wierzchołków do shadera fragmentów i wyświetl ją.

|

||||

|

||||

W shaderze wierzchołków obok deklaracji `out vec4 color;` dodaj analogiczne o nazwie `pos_local` i `pos_global`. Do `pos_local` przypisz `vertexPosition`, a do `pos_global` przypisz `transformation * vertexPosition`. Podobnie dopisz odebranie ich w shaderze fragmentów. Użyj `pos_local`, następnie `pos_global` jako zamiast koloru. Dlaczego otrzymaliśmy taki efekt?

|

||||

|

||||

### Zadanie*

|

||||

Użyj jednej ze zmiennych z poprzedniego zadania do zrobienia pasków na przynajmniej jednej ze ścian sześcianu. Wykorzystaj czas, żeby paski się przesuwały.

|

||||

|

||||

101

grk/cw 6/Zadania 4.html

Normal file

@ -0,0 +1,101 @@

|

||||

<!DOCTYPE html>

|

||||

<html xmlns="http://www.w3.org/1999/xhtml" lang="" xml:lang="">

|

||||

<head>

|

||||

<meta charset="utf-8" />

|

||||

<meta name="generator" content="pandoc" />

|

||||

<meta name="viewport" content="width=device-width, initial-scale=1.0, user-scalable=yes" />

|

||||

<title>Zadania 4</title>

|

||||

<style>

|

||||

code{white-space: pre-wrap;}

|

||||

span.smallcaps{font-variant: small-caps;}

|

||||

span.underline{text-decoration: underline;}

|

||||

div.column{display: inline-block; vertical-align: top; width: 50%;}

|

||||

div.hanging-indent{margin-left: 1.5em; text-indent: -1.5em;}

|

||||

ul.task-list{list-style: none;}

|

||||

</style>

|

||||

|

||||

<style>

|

||||

.code-block {

|

||||

background-color: #f4f4f4;

|

||||

border-left: 5px solid #f36d33;

|

||||

margin: 20px 0;

|

||||

padding: 10px 20px;

|

||||

font-family: Consolas, "Courier New", Courier, monospace;

|

||||

color: #333;

|

||||

overflow: auto;

|

||||

}

|

||||

</style>

|

||||

|

||||

<link rel="stylesheet" href="style.css" />

|

||||

<script src="https://cdn.jsdelivr.net/npm/mathjax@3/es5/tex-chtml-full.js" type="text/javascript"></script>

|

||||

<!--[if lt IE 9]>

|

||||

<script src="//cdnjs.cloudflare.com/ajax/libs/html5shiv/3.7.3/html5shiv-printshiv.min.js"></script>

|

||||

<![endif]-->

|

||||

</head>

|

||||

<body>

|

||||

<h2 id="ładowanie-obiektów-za-pomocą-assimpa">Ładowanie obiektów za pomocą Assimp</h2>

|

||||

<p>W projekcie zaimplementowano ładowanie modeli przy użyciu biblioteki Assimp. Obiekty są ładowane za pomocą funkcji <code>loadModelToContext(std::string path, Core::RenderContext& context)</code>. Pierwszym argumentem tej funkcji jest ścieżka, pod którą znajduje się model, a drugim jest referencja do <code>RenderContext</code>. Ta struktura przechowuje informacje o modelu, m.in. o jego VAO czy liczbie wierzchołków. Rysowanie obiektu odbywa się za pomocą funkcji <code>Core::DrawContext(Core::RenderContext& context)</code>. Obecnie na przykładzie rysowana jest sfera ładowana z pliku.</p>

|

||||

<p>Podczas poprzednich zadań zdefiniowaliśmy funkcje tworzące macierze widoku i projekcji. Aby narysować model, należy najpierw zdefiniować macierz modelu, przemnożyć ją przez macierz kamery i macierz widoku, a następnie wysłać ją do GPU i dopiero potem narysować model. Te operacje są bardzo powtarzalne, dlatego można je przenieść do osobnej funkcji. W pliku <code>ex_4_1.hpp</code> znajduje się funkcja <code>drawObjectColor</code>, która przyjmuje rysowany obiekt jako <code>Core::RenderContext&</code>, macierz modelu jako <code>glm::mat4</code> oraz kolor jako <code>glm::vec3</code>. <h3 id="zadanie">Zadanie</h3> Wszystkie obiekty rysowane przez <code>drawObjectColor</code> są w jednym kolorze – napraw to. Wewnątrz funkcji przekaż kolor jako <code>uniform</code> do GPU (za pomocą funkcji <code>glUniform3f</code>) i odpowiednio zmodyfikuj shader fragmentów, aby wyznaczyć go jako kolor wyjściowy.</p>

|

||||

<p>Korzystając z tej funkcji, stwórz układ słoneczny z przynajmniej jedną planetą, która posiada księżyc. Planeta powinna poruszać się wokół słońca, a księżyc wokół planety.</p>

|

||||

<h3 id="zadanie">Zadanie*</h3>

|

||||

<p>Rozbuduj układ planetarny do przynajmniej 5 planet i pasa asteroid. Ściągnij z internetu/stwórz kilka prostych modeli asteroid, z których zbudujesz pas asteroid.</p>

|

||||

<h3 id="zadanie-1">Zadanie</h3>

|

||||

<p>Celem tego zadania jest dodanie statku, który będzie latać po układzie planetarnym.</p>

|

||||

<p>Załaduj model statku, który jest w pliku <code>spaceship.obj</code>. Stwórz zmienne globalne <code>spaceshipPos</code> oraz <code>spaceshipDir</code>, które będą określać pozycję i kierunek, w którym statek się porusza. Później będziemy je zmieniać za pomocą przycisków, na razie wewnątrz funkcji <code>processInput</code> przypisz do nich odpowiednio <code>cameraPos+1.5*cameraDir+glm::vec3(0,-0.5f,0)</code> oraz <code>cameraDir</code>. W ten sposób po prawidłowym ustawieniu macierzy statek będzie znajdował się zawsze przed kamerą.</p>

|

||||

<p>Przesuń i obróć statek w odpowiedni sposób. Przesunięcie zrealizujemy przez translację do <code>spaceshipPos</code> natomiast macierz statku liczy się tak samo, jak macierz kamery, tylko zamiast <code>-cameraDir</code> bierzemy <code>spaceshipDir</code> i na końcu trzeba tę macierz odwrócić (lub transponować, co jest tym samym, ponieważ mówimy o macierzy ortonormalnej).</p>

|

||||

<h3 id="zadanie-2">Zadanie</h3>

|

||||

<h3 id="zadanie-3">Zadanie*</h3>

|

||||

<p>Obecnie klawisze regulują ustawienia kamery, do której jest podpięty statek. Zmodyfikuj aplikację, aby klawisze umożliwiały poruszanie się statkiem, a kamera podążała za nim. W tym celu w obsłudze klawiatury modyfikuj wektory <code>spaceshipPos</code> i <code>spaceshipDir</code>. Następnie dostosuj <code>cameraPos</code> i <code>cameraDir</code> w zależności od wektorów <code>spaceshipPos</code> i <code>spaceshipDir</code>.</p>

|

||||

<h3 id="zadanie-4">Zadanie*</h3>

|

||||

<p>Obecnie szybkość ruchu statku lub kamery zależy od liczby klatek, co może powodować różne efekty na różnych komputerach, co nie jest pożądane. Aby to skorygować, musimy obliczyć czas, jaki upłynął między poszczególnymi klatkami i dostosować do niego przesunięcia oraz obroty. Utwórz zmienne globalne <code>float lastFrameTime</code> oraz <code>float deltaTime</code>, następnie w funkcji <code>renderScene</code> dodaj oblicz <code>deltaTime = time-lastFrameTime</code> i przypisz do zmiennej <code>lastFrameTime</code> wartość <code>time</code>. Nie chcemy, żeby wartość <code>deltaTime</code> była zbyt duża, gdy nagle spadnie liczba klatek, dlatego ucinamy ją od góry przez <code>0.1</code>.</p>

|

||||

<p>Wykorzystaj <code>deltaTime</code> w funkcji <code>processInput</code> aby uniezależnić prędkość poruszania się od liczby klatek na sekundę.</p>

|

||||

<h3 id="zadanie-5">Zadanie*</h3>

|

||||

<p>Zastąp model statku innym modelem.</p>

|

||||

|

||||

<h2 id="bufor-głębokości">Bufor głębokości</h2>

|

||||

<p>Bufor głębokości rejestruje odległość danego piksela od kamery. Pozwala to podczas rysowania kolejnych obiektów odrzucić piksele, które znajdowałyby się za już narysowanymi. Ten mechanizm jest automatycznie, żeby go uruchomić, wystarczy dodać instrukcję <code>glEnable(GL_DEPTH_TEST)</code>, poza tym przed rysowaniem klatki należy wyczyścić bufor głębokości, co robimy w instrukcji <code>glClear(GL_COLOR_BUFFER_BIT | GL_DEPTH_BUFFER_BIT)</code>.</p>

|

||||

<h3 id="zadanie-7">Zadanie</h3>

|

||||

<p>Sprawdź, co się stanie, gdy nie włączymy <code>glEnable(GL_DEPTH_TEST)</code> oraz sprawdź co, się dzieje, gdy nie czyścimy żadnego bufora lub gdy czyścimy tylko bufor koloru czy tylko bufor głębokości. Dlaczego dzieje się to, co widzisz?</p>

|

||||

<h2 id="wizualizacja-bufora-głębokości">Wizualizacja bufora głębokości</h2>

|

||||

<p>W tej części zwizualizujemy jak wygląda bufor głębokości przy pomocy skali szarości. Zrealizujemy poprzez napisanie odpowiedniego shadera.</p>

|

||||

<blockquote>

|

||||

<p><strong>Uwaga</strong> nie jest to faktycznie rysowanie bufora głębokości, to wymagałoby stworzenie FrameBufferObject renderowanie głębokości do niego i narysowanie wyniku na ekranie. Zrobimy to na późniejszych zajęciach przy okazji rysowania cieni.</p>

|

||||

</blockquote>

|

||||

<p>Wykorzystamy wbudowaną zmienną <code>gl_FragCoord</code> we fragment shaderze. Zawiera ona informacje o pozycji fragmentu.</p>

|

||||

<h3 id="zadanie-8">Zadanie</h3>

|

||||

<p>We fragment shaderze podmień wartości R G B w shaderze fragmentów na <code>gl_FragCoord.z</code>.</p>

|

||||

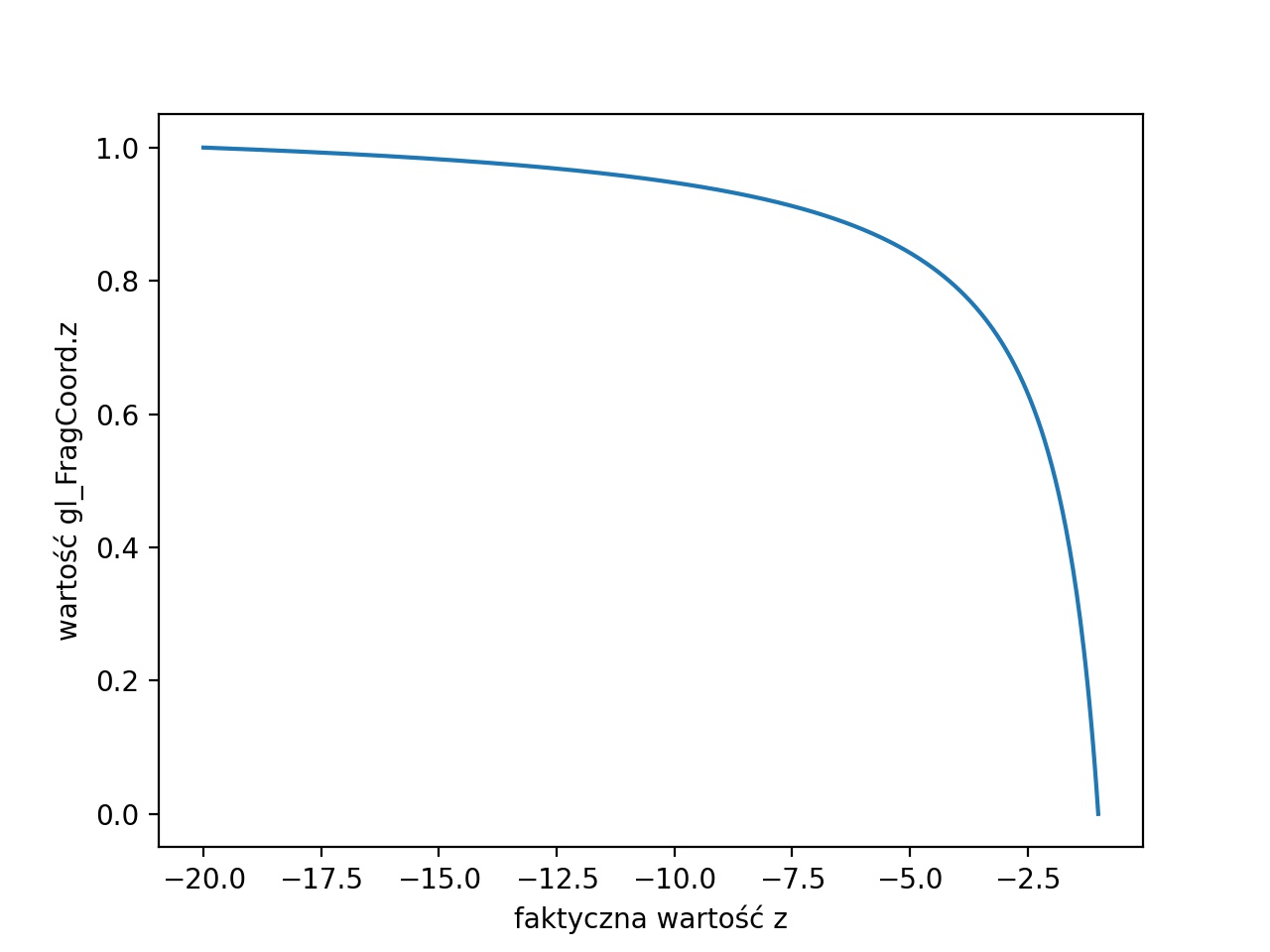

<p>Zauważ, że obiekty są bardzo jasne i stają się ciemniejsze, dopiero gdy kamera podjedzie bardzo blisko. Wynika to z tego, że wartości <code>z</code> w <code>gl_FragCoord</code> nie są liniowe ze względu na rzutowanie perspektywiczne omówione na poprzednich zajęciach. Poniższy wykres prezentuje przykładową różnicę między faktyczną wartością a wartością w <code>gl_FragCoord</code>. <img src="./img/z_depth_graph2.jpg" /></p>

|

||||

<p>My chcielibyśmy wyświetlać je liniowo. W tym celu będziemy musieli wrócić do współrzędnych w przestrzeni świata. Zauważ, że wartości <code>gl_FragCoord.z</code> są z zakresu od <span class="math inline">\([0,1]\)</span> a nie <span class="math inline">\([-1,1]\)</span> jak są zapisane współrzędne w przestrzeni ekranu. Dlatego pierwszym krokiem będzie przekonwertowanie ich (poprzez pomnożenie przez 2 i odjęcie 1). Współrzędne w przestrzeni ekranu obliczamy wzorem <span class="math display">\[z'=-\frac{(n + f)}{(n - f)}- \frac{(2 n f)}{z(n - f)}.\]</span>My chcemy obliczyć <span class="math inline">\(z\)</span> po przekształceniu wzoru otrzymujemy: <span class="math display">\[z=\frac{-2nf}{z'(n-f)+n+f}.\]</span> <h3 id="zadanie-9">Zadanie</h3> We fragment shaderze uwórz funkcję, która oblicza <span class="math inline">\(z\)</span> i wyświetl zlinearyzowaną odległość. Pamiętaj, że wartość <span class="math inline">\(z\)</span> jest z zakresu od <span class="math inline">\(n\)</span> do <span class="math inline">\(f\)</span>, dlatego zmień podziel ją przez <span class="math inline">\(-f\)</span> przed rysowaniem.</p>

|

||||

<h3 id="zadanie-9">Zadanie</h3>

|

||||

<p>Wykorzystaj informację o odległości, żeby dodać do sceny efekt mgły. Zmieszaj kolor (funkcja "mix" w glsl) obiektu z kolorem tła, jako współczynnik weź wartość z poprzedniego zadania.</p>

|

||||

<h2 id="kreatywne-wykorzystanie-bufora-głębokości">Kreatywne wykorzystanie bufora głębokości</h2>

|

||||

<p>Czasem chcielibyśmy, żeby niektóre wyświetlane elementy były inaczej traktowane przez bufor głębokości. Przykładowo chcielibyśmy stworzyć bardziej złożone tło dla naszej sceny. Chcemy wtedy, żeby to tło było ,,za’’ każdym innym obiektem w scenie. Możemy to osiągnąć poprzez namalowanie tła na początku, a następnie usunięcie zawartości bufora głębokości.</p>

|

||||

<h3 id="zadanie-10">Zadanie*</h3>

|

||||

<p>Dodaj jakiś rodzaj tła w sposób opisany powyżej. Mogą być to na przykład małe sfery udające gwiazdy. Prostokąt w przestrzeni ekranu, który będzie zmieniał kolory czy kręcący się prostopadłościan.</p>

|

||||

<h2 id="kreatywne-wykorzystanie-bufora-głębokości">Implementacja ruchu kamery w symulatorze kosmicznym bez synchronizacji modelu statku</h2>

|

||||

<h3 id="zadanie-6">Zadanie*</h3>

|

||||

<p>W tym ćwiczeniu zajmiemy się implementacją systemu kontroli kamery, który pozwoli na interaktywne sterowanie widokiem w symulatorze lotu. Będzie to wymagało obsługi wejścia myszy do kontroli ruchów pitch i yaw. Dodaj nastepujace zmienne globalne do kodu.

|

||||

<pre class="code-block"><code>

|

||||

float pitch = 0.0f;

|

||||

float yaw = -90.0f;

|

||||

float lastX = 800.0f / 2.0;

|

||||

float lastY = 600.0 / 2.0;

|

||||

bool firstMouse = true;

|

||||

</code></pre></p>

|

||||

Zaimplementuj w funkcji processinput logikę odpowiedzialną za przetwarzanie wejścia myszy. Użyj funkcji glfwGetCursorPos do uzyskania bieżącej pozycji kursora. Dodaj zmienną sensitivity do regulacji czułości myszy. Na początku sprawdzamy, czy jest to pierwsze uchwycenie pozycji myszy po uruchomieniu aplikacji. Jeśli tak, to zapisujemy bieżącą pozycję myszy jako punkt odniesienia (lastX i lastY) i ustawiamy zmienną firstMouse na false. To zapobiega gwałtownemu skoku kamery, gdybyśmy po raz pierwszy poruszyli myszą. Następnie obliczamy różnicę (xoffset i yoffset) między aktualną pozycją kursora a ostatnią zapisaną pozycją. Zauważ, że wartość yoffset jest odwrócona, ponieważ w systemach okienkowych współrzędna y zwykle rośnie w dół ekranu, a chcemy, aby ruch w górę odpowiadał wzrostowi kąta widzenia kamery. Po obliczeniu przesunięć skalujemy je wartością sensitivity, która pozwala na dostosowanie reakcji kamery na ruch myszy. Mała wartość czułości sprawi, że kamera będzie reagować łagodniej, podczas gdy większa wartość uczyni ruchy bardziej gwałtownymi. Na koniec, dodajemy przeskalowane przesunięcia do naszych kątów orientacji kamery: yaw (odpowiedzialny za obrót wokół osi pionowej) i pitch (odpowiedzialny za obrót wokół osi poziomej). Trzeba tu uważać, aby nie przekroczyć pewnych granic. Na przykład, nie chcemy, aby kamera "przewracała się" do góry nogami, dlatego ograniczamy kąt pitch do wartości pomiędzy -89 a 89 stopni. Dodaj logikę do ograniczenia kąta pitch, aby uniknąć "przewrócenia" kamery.

|

||||

<pre class="code-block"><code> if (pitch > 89.0f)

|

||||

pitch = 89.0f;

|

||||

if (pitch < -89.0f)

|

||||

pitch = -89.0f;

|

||||

</code></pre></p>

|

||||

Zastosuj funkcje trygonometryczne do przeliczenia kątów na wektor kierunku kamery:<pre class="code-block"><code>

|

||||

glm::vec3 front;

|

||||

front.x = cos(glm::radians(yaw)) * cos(glm::radians(pitch));

|

||||

front.y = sin(glm::radians(pitch));

|

||||

front.z = sin(glm::radians(yaw)) * cos(glm::radians(pitch));

|

||||

cameraDir = glm::normalize(front);</code></pre></p>

|

||||

|

||||

Na zakończenie ćwiczenia oczekujemy, że symulator będzie poprawnie implementował ruch kamery, lecz dołączony model statku kosmicznego nie będzie jeszcze obracał się razem z kamerą.

|

||||

|

||||

</body>

|

||||

</html>

|

||||

74

grk/cw 6/Zadania 4.md

Normal file

@ -0,0 +1,74 @@

|

||||

## Ładowanie obiektów za pomocą assimpa

|

||||

|

||||

W projekcie zaimplentowane jest ładowanie modeli z użyciem biblioteki assimp. Obiekty ładuje się za pomocą funkcji `loadModelToContext(std::string path, Core::RenderContext& context)` pierwszym jej argumentem jest ścieżka, pod którą znajduje się model, drugim argumentem jest referencja do `RenderContext`. Ta struktura przechowuje informacje o modelu, m.in. jego VAO czy liczba wierzchołku. Rysuje się go za pomocą funkcji `Core::DrawContext(Core::RenderContext& context)`. Teraz przykładowo rysowana jest sfera ładowana z pliku.

|

||||

|

||||

W trakcie poprzednich zadań zdefiniowaliśmy funkcje tworzące macierze widoku i projekcji. Aby narysować model, należy najpierw zdefiniować macierz modelu, przemnożyć ją przez macierz kamery i macierz widoku i wysłać ją do GPU i dopiero narysować model. Te operacje są bardzo powtarzalne i można je przenieść do osobnej funkcji. Dlatego w `ex_4_1.hpp` znajduje funkcja `drawObjectColor` która przyjmuje rysowany obiekt jako `Core::RenderContext&`, macierz modelu jako `glm::mat4` i kolor jako `glm::vec3`.

|

||||

### Zadanie

|

||||

Wszystkie obiekty rysowane przez `drawObjectColor` rysują się na jeden kolor, napraw to. Wewnątrz funkcji prześlij kolor jako `uniform` do GPU (za pomocą funkcji `glUniform3f`) i tak zmodyfikuj shader fragmentów, żeby ustalić go kolorem wyjściowym.

|

||||

|

||||

Korzystając z tej funkcji, stwórz układ słoneczny z przynajmniej jedną planetą, która posiada księżyc. Planeta powinna poruszać się wokół słońca a księżyc wokół planety.

|

||||

|

||||

### Zadanie*

|

||||

Rozbuduj układ planetarny do przynajmniej 5 planet i pasa asteroid. Ściągnij z internetu/stwórz kilka prostych modeli asteroid, z których zbudujesz pas asteroid.

|

||||

|

||||

### Zadanie

|

||||

Celem tego zadania jest dodanie statku, który będzie latać po układzie planetarnym.

|

||||

|

||||

Załaduj model statku, który jest w pliku `spaceship.obj`. Stwórz zmienne globalne `spaceshipPos` oraz `spaceshipDir`, które będą określać pozycję i kierunek, w którym statek się porusza. Później będziemy je zmieniać za pomocą przycisków, na razie wewnątrz funkcji `processInput` przypisz do nich odpowiednio `cameraPos+1.5*cameraDir+glm::vec3(0,-0.5f,0)` oraz `cameraDir`. W ten sposób po prawidłowym ustawieniu macierzy statek będzie znajdował się zawsze przed kamerą.

|

||||

|

||||

Przesuń i obróć statek w odpowiedni sposób. Przesunięcie zrealizujemy przez translację do `spaceshipPos` natomiast macierz statku liczy się tak samo, jak macierz kamery, tylko zamiast `cameraDir` bierzemy `spaceshipDir` i na końcu trzeba tę macierz odwrócić (lub transponować, co jest tym samym, ponieważ mówimy o macierzy ortonormalnej).

|

||||

|

||||

Możliwe, że model nie jest skierowany w stronę tej samej osi, co domyślnie w openGL, w tym wypadku musisz dodać dodatkową rotację o stały kąt, która naprawi ten problem.

|

||||

|

||||

### Zadanie

|

||||

|

||||

### Zadanie*

|

||||

W tej chwili klawisze ustawiają kamerę, do której podczepiony jest statek. Zmodyfikuj aplikację, żeby klawisze przesuwały statek, a kamera była do niego podczepiona. Aby to zrobić, wystarczy w obsłudze klawiatury modyfikować wektory `spaceshipPos` i `spaceshipDir`. Natomiast `cameraPos` i `cameraDir` uzależnić od wektorów `spaceshipPos` i `spaceshipDir`.

|

||||

|

||||

### Zadanie*

|

||||

W tej chwili szybkość poruszania się statku/kamery jest uzależniona od liczby klatek, co daje różne efekty na różnych komputerach i jest raczej niepożądane. Aby to naprawić, musimy obliczyć, ile czasu minęło między klatkami i od tego uzależnić przesunięcia oraz obroty. Utwórz zmienne globalne `float lastFrameTime` oraz `float deltaTime`, następnie w funkcji `renderScene` dodaj oblicz `deltaTime = time-lastFrameTime` i przypisz do zmiennej `lastFrameTime` wartość `time`. Nie chcemy, żeby wartość `deltaTime` była zbyt duża, gdy nagle spadnie liczba klatek, dlatego ucinamy ją od góry przez `0.1`.

|

||||

|

||||

Wykorzystaj `deltaTime` w funkcji `processInput` aby uniezależnić prędkość poruszania się od liczby klatek na sekundę.

|

||||

|

||||

### Zadanie*

|

||||

Podmień model statku na jakiś inny.

|

||||

|

||||

### Zadanie**

|

||||

dodaj obsługę myszki, która będzie obracać kamerą.

|

||||

|

||||

## Bufor głębokości

|

||||

|

||||

Bufor głębokości zapisuje, w jakiej odległości od kamery znajduje dany piksel. Dzięki temu przy rysowaniu kolejnych obiektów można odrzucić te piksele, które znajdowałyby się za narysowanymi. Ten mechanizm jest automatycznie, żeby go uruchomić, wystarczy dodać instrukcję `glEnable(GL_DEPTH_TEST)`, poza tym przed rysowaniem klatki należy wyczyścić bufor głębokości, co robimy w instrukcji `glClear(GL_COLOR_BUFFER_BIT | GL_DEPTH_BUFFER_BIT)`.

|

||||

|

||||

### Zadanie

|

||||

Sprawdź, co się stanie, gdy nie włączymy `glEnable(GL_DEPTH_TEST)` oraz sprawdź co, się dzieje, gdy nie czyścimy żadnego bufora lub gdy czyścimy tylko bufor koloru czy tylko bufor głębokości. Dlaczego dzieje się to, co widzisz?

|

||||

|

||||

|

||||

## Wizualizacja bufora głębokości

|

||||

|

||||

W tej części zwizualizujemy jak wygląda bufor głębokości przy pomocy skali szarości. Zrealizujemy poprzez napisanie odpowiedniego shadera.

|

||||

|

||||

> **Uwaga** nie jest to faktycznie rysowanie bufora głębokości, to wymagałoby stworzenie FrameBufferObject renderowanie głębokości do niego i narysowanie wyniku na ekranie. Zrobimy to na późniejszych zajęciach przy okazji rysowania cieni.

|

||||

|

||||

Wykorzystamy wbudowaną zmienną `gl_FragCoord` we fragment shaderze. Zawiera ona informacje o pozycji fragmentu.

|

||||

|

||||

### Zadanie

|

||||

We fragment shaderze podmień wartości R G B w shaderze fragmentów na `gl_FragCoord.z`.

|

||||

|

||||

Zauważ, że obiekty są bardzo jasne i stają się ciemniejsze, dopiero gdy kamera podjedzie bardzo blisko. Wynika to z tego, że wartości `z` w `gl_FragCoord` nie są liniowe ze względu na rzutowanie perspektywiczne omówione na poprzednich zajęciach. Poniższy wykres prezentuje przykładową różnicę między faktyczną wartością a wartością w `gl_FragCoord`.

|

||||

|

||||

|

||||

My chcielibyśmy wyświetlać je liniowo. W tym celu będziemy musieli wrócić do współrzędnych w przestrzeni świata.

|

||||

Zauważ, że wartości `gl_FragCoord.z` są z zakresu od $[0,1]$ a nie $[-1,1]$ jak są zapisane współrzędne w przestrzeni ekranu. Dlatego pierwszym krokiem będzie przekonwertowanie ich (poprzez pomnożenie przez 2 i odjęcie 1). Współrzędne w przestrzeni ekranu obliczamy wzorem $$z'=-\frac{(n + f)}{(n - f)}- \frac{(2 n f)}{z(n - f)}.$$My chcemy obliczyć $z$ po przekształceniu wzoru otrzymujemy:

|

||||

$$z=\frac{-2nf}{z'(n-f)+n+f}.$$

|

||||

### Zadanie

|

||||

We fragment shaderze uwórz funkcję, która oblicza $z$ i wyświetl zlinearyzowaną odległość. Pamiętaj, że wartość $z$ jest z zakresu od $n$ do $f$, dlatego zmień podziel ją przez $f$ przed rysowaniem.

|

||||

|

||||

### Zadanie*

|

||||

Wykorzystaj informację o odległości, żeby dodać do sceny efekt mgły. Zmieszaj kolor obiektu z kolorem tła, jako współczynnik weź wartość z poprzedniego zadania.

|

||||

|

||||

## Kreatywne wykorzystanie bufora głębokości

|

||||

Czasem chcielibyśmy, żeby niektóre wyświetlane elementy były inaczej traktowane przez bufor głębokości. Przykładowo chcielibyśmy stworzyć bardziej złożone tło dla naszej sceny. Chcemy wtedy, żeby to tło było ,,za'' każdym innym obiektem w scenie. Możemy to osiągnąć poprzez namalowanie tła na początku, a następnie usunięcie zawartości bufora głębokości.

|

||||

|

||||

### Zadanie

|

||||

Dodaj jakiś rodzaj tła w sposób opisany powyżej. Mogą być to na przykład małe sfery udające gwiazdy. Prostokąt w przestrzeni ekranu, który będzie zmieniał kolory czy kręcący się prostopadłościan.

|

||||

92

grk/cw 6/Zadania 5.md

Normal file

@ -0,0 +1,92 @@

|

||||

## Oświetlenie Phonga

|

||||

W trakcie tych zajęć zajmiemy się implementacją modelu oświetlenia Phonga. Na poprzednich zajęciach zbudowaliśmy układ słoneczny. Wykorzystamy go w trakcie tych zajęć. Jeżeli go zrobiłeś, to przekopiuj do `ex_5_1.hpp` kod z poprzednich zajęć. W przeciwnym wypadku wykorzystaj ten, który jest zaimplementowany w `ex_5_1.hpp`. W zadaniu będzie nam potrzebny statek latający przed kamerą, jak nie ma tego w Twojej scenie to skopiuj to z `ex_5_1.hpp`.

|

||||

|

||||

|

||||

## Zadanie - *diffuse*

|

||||

Oblicz we fragment shaderze oświetlenie obiektu przy użyciu modelu Phonga dla odbicia rozproszonego (*diffuse)

|

||||

1. Przekaż źródło światła. Na razie przyjmiemy kierunkowy model oświetlenia, dlatego źródło będzie opisane jako wektor kierunkowy:

|

||||

|

||||

- Prześlij do shadera fragmentów zmienna typu `uniform vec3` (nazwij ją np. `lightDir`), w której będzie się znajdować wektor kierunkowy.

|

||||

- Należy to zrobić podobnie do tego, jak przesyłany jest kolor.

|

||||

- Jako kierunek światła wybierz dowolny wektor jednostkowy. (Możesz wziąć dowolny niezerowy wektor następnie go znormalizować).

|

||||

|

||||

* Dodatkowo prześlij drugą zmienną `uniform vec3 lightColor`, w której umieścimy kolor światła. Prześlij tam wartości ze zmiennej `glm::vec3 lightColor`.

|

||||

|

||||

2. Oblicz natężenie w shaderze fragmentów:

|

||||

- prześlij normalne z shadera fragmentów do shadera wierzchołków

|

||||

- znormalizuj wektor normalny przed użyciem go w obliczeniach (uśrednianie wektorów normalnych wierzchołków może spowodować, że przestaje one być jednostkowe).

|

||||

|

||||

- Natężenie to iloczyn skalarny wektora normalnego powierzchni i odwrotnego wektora kierunku padania światła. Skorzystaj z funkcji `dot`.

|

||||

|

||||

- Natężenie nie może być ujemne. Przytnij natężenie do zera przy użyciu: `x = max(x, 0.0)`

|

||||

3. Zastosuj obliczone natężenie, aby zmodyfikować kolor obiektu:

|

||||

- Przemnóż kolor RGB fragmentu przez obliczone natężenie i przez kolor światła z `lightColor`.

|

||||

|

||||

## Zadanie - obsługa obrotów

|

||||

Dlaczego oświetlenie statku nie zmienia się podczas jego obracania?

|

||||

|

||||

(Wektory normalne są w układzie lokalnym modelu, a wektor padania światła w układzie świata)

|

||||

|

||||

Należy wykonać transformacje wektorów normalnych do przestrzeni świata:

|

||||

- Prześlij macierz modelu rysowanego obiektu (_model Matrix_) jako osobna zmienna do vertex shadera (`uniform mat4`).

|

||||

- Przemnóż przez te macierz wektor normalny wierzchołka przed przesłaniem go do shadera fragmentów.

|

||||

- Współrzędna **w** dopisana do wektora przed mnożeniem przez macierz powinna być ustawiona na 0. Wynika to z tego, że w przypadku transformacji wektorów reprezentujących kierunki w przestrzeni, nie chcemy dokonywać translacji — np. wektor normalny do powierzchni zależy od orientacji obiektu, ale nie od jego pozycji (przesunięcia) w przestrzeni świata.

|

||||

|

||||

|

||||

## Zadanie - *specular*

|

||||

Uzupełnił model o czynnik odbicia zwierciadlanego (*specular*). W tym celu:

|

||||

|

||||

1. Potrzebny będzie wektor od rysowanego fragmentu do pozycji kamery:

|

||||

- Wyślij pozycje kamery (`cameraPos`) jako kolejna zmienna do fragment shadera.

|

||||

- Podobnie jak wektory normalne prześlij z vertex do fragment shadera pozycje wierzchołków (`vertexPosition`) w przestrzeni świata (czyli pomnożone przez macierz **modelMatrix**). Pamiętaj, że tym razem wektory reprezentują punkty, a nie kierunki - współrzędna **w** przed mnożeniem musi być ustawiona na 1. W wyniku rasteryzacji otrzymamy w shaderze fragmentu jego pozycję (nazywaną pozycją fragmentu)

|

||||

- Oblicz wektor **V** (_view direction_) jako znormalizowaną różnice pozycji kamery i pozycji fragmentu.

|

||||

|

||||

2. Oblicz natężenie światła odbitego we _fragment shaderze_:

|

||||

- Oblicz wektor kierunku odbicia światła **R** przy użyciu funkcji [`reflect`](https://www.khronos.org/registry/OpenGL-Refpages/gl4/html/reflect.xhtml). Pamiętaj, żeby przesłać do funkcji odwrócony wektor kierunku światła.

|

||||

- Oblicz natężenie: iloczyn skalarny **V** i **R**, przycięty do zera ( `max(...,0.0)` ), a następnie podniesiony do wysokiej potęgi (np. 8, 50, 1000), która jest miara połyskliwości powierzchni.

|

||||

|

||||

3. Ustal ostateczny kolor piksela na `objectColor * diffuse + lightColor * specular`. Oznacza to najprostszy przypadek, gdy kolor światła odbitego jest biały.

|

||||

|

||||

|

||||

## Zadanie - oświetlenie punktowe

|

||||

W układzie planetarnym obiektem oświetlającym powinno być słońce, dlatego zamień oświetlenie kierunkowe na punktowe:

|

||||

|

||||

- Zamiast przesyłać (w `lightDir`) kierunek światła, prześlij pozycję słońca do fragment shadera (taką jak ustawiłeś w punkcie powyżej) jako uniform vec3 (nazwij go `lightPos`).

|

||||

- Oblicz kierunek światła odejmując od pozycji fragmentu pozycję światła, znormalizuj wynik. Zapisz wynik w zmiennej `lightDir`.

|

||||

- Słońce będzie czarne, nie martw się tym, tylko spójrz na punkt następny.

|

||||

|

||||

## Zadanie - shader słońca

|

||||

Źródło światła znajduje się wewnątrz kuli, która reprezentuje słońce, dlatego jest czarna. By to naprawić, utwórz osobny shader, który będzie odpowiadać za renderowanie słońca.

|

||||

|

||||

Celem tego zadania jest stworzenie shadera (**shader_4_sun.vert**_ i **shader_4_sun.frag**), który będzie odpowiadał wyłącznie za rysowanie słońca. Poprzednie shadery (**shader_4_1.vert**_ i **shader_4_1.frag**) nadal mają rysować pozostałe obiekty. a) zainicjalizuj _program_ (shadery): - Pliki **shader_4_sun.vert** i **shader_4_sun.frag** są identyczne z 4_1** przed zmianami, będą punktem wyjścia dla _shadera_ słońca.

|

||||

|

||||

1. Utwórz zmienną globalną `GLuint programSun` na adres shadera słońca. Stwórz _program_ za pomocą `shaderLoader.CreateProgram` analogicznie jak tworzy się `program` z **shader_4_1.vert** i **shader_4_1.frag** (parametry wejściowe to ścieżka do shadera wierzchołków i fragmentów **shader_4_sun.vert** i **shader_4_sun.frag**).

|

||||

|

||||

2. W skomplikowanym projekcie różne typy obiektów rysuje się przy użyciu różnych shaderów, zate potrzebna jest w programie architektura, która na to pozwala. Ustaw odpowiedni _program_ (shadery) do rysowania słońca:

|

||||

- funkcja `drawObject` korzysta z globalnej zmiennej `program`, żeby wskazywać shadery do rysowania. Dodaj argument do funkcji, który będziesz przekazywać adres _programu_, który ma być wykorzystany do rysowania.

|

||||

- dodaj odpowiedni _program_ w wywołaniach `drawObject`.

|

||||

|

||||

## Osłabienie światła, tone mapping

|

||||

### Zadanie - Osłabienie światła (attenuation)

|

||||

Światło pochodzące z punktowego źródła traci na sile wraz z dystansem. Wynika to z tego, że rozprasza się na większą powierzchnię.

|

||||

Dodaj ten efekt do shadera. Zamiast brać kolor światła bezpośrednio, podziel go przez kwadrat dystansu od źródła świata.

|

||||

|

||||

#### Tone mapping

|

||||

Przez obecną zmianę scena stała się ciemna. Wymaga to od nas zmiany 'koloru' światła na wartości dużo większe niż do tej pory. Jeśli teraz to zrobimy i przesadzimy w drugą stronę, otrzymamy efekt prześwietlenia. Wynika to z ograniczenia zakresu kolorów do $[0,1]$ (obsługą wyższych wartości nazywamy HDR). Rozwiązaniem jest pracowanie na wartościach powyżej 1 wykorzystanie *tone mappingu* do przeniesienia ich w zakres $[0,1]$. Istnieje wiele wzorów, które są wykorzystywane do tego, jeden z nich to:

|

||||

|

||||

$$C_{mapped} = 1-e^{-C * E},$$

|

||||

gdzie C to kolor sceny a E to parametr ekspozycji (z zakresu $(0,\infty)$, który może być dostosowany w zależności od jasności.

|

||||

### Zadanie - Tone mapping*

|

||||

Zwiększ siłę słońca przynajmniej stukrotnie. Zaimplementuj powyższą metodę tone mappingu i dodaj możliwość sterowania ekspozycją za pomocą klawiszy 1 i 2.

|

||||

|

||||

### Zadanie*

|

||||

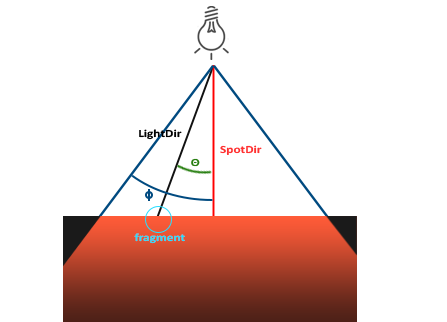

Dodaj drugie źródło oświetlenia w postaci reflektora statku. Reflektor świeci tylko w określonym stożku,dlatego oprócz pozycji `spotPos` posiada również kierunek `spotDir` i kąt świecenia $\phi$. Po obliczeniu dla niego `lightDir` należy sprawdzić, czy iloczyn skalarny pomiędzy `lightDir` a `spodDir` jest większy niż $\cos\phi$ . Jeżeli nie jest, to stożek nie świeci w tym miejscu. Można ułatwić sobie implementację wielu źródeł światła poprzez przeniesienie obliczeń oświetlenia do funkcji, która przyjmuje kierunek światła i siłę naświetlenie.

|

||||

|

||||

Zwróć uwagę, że SpotDir to co innego niż light Dir w poprzednich zadaniach

|

||||

|

||||

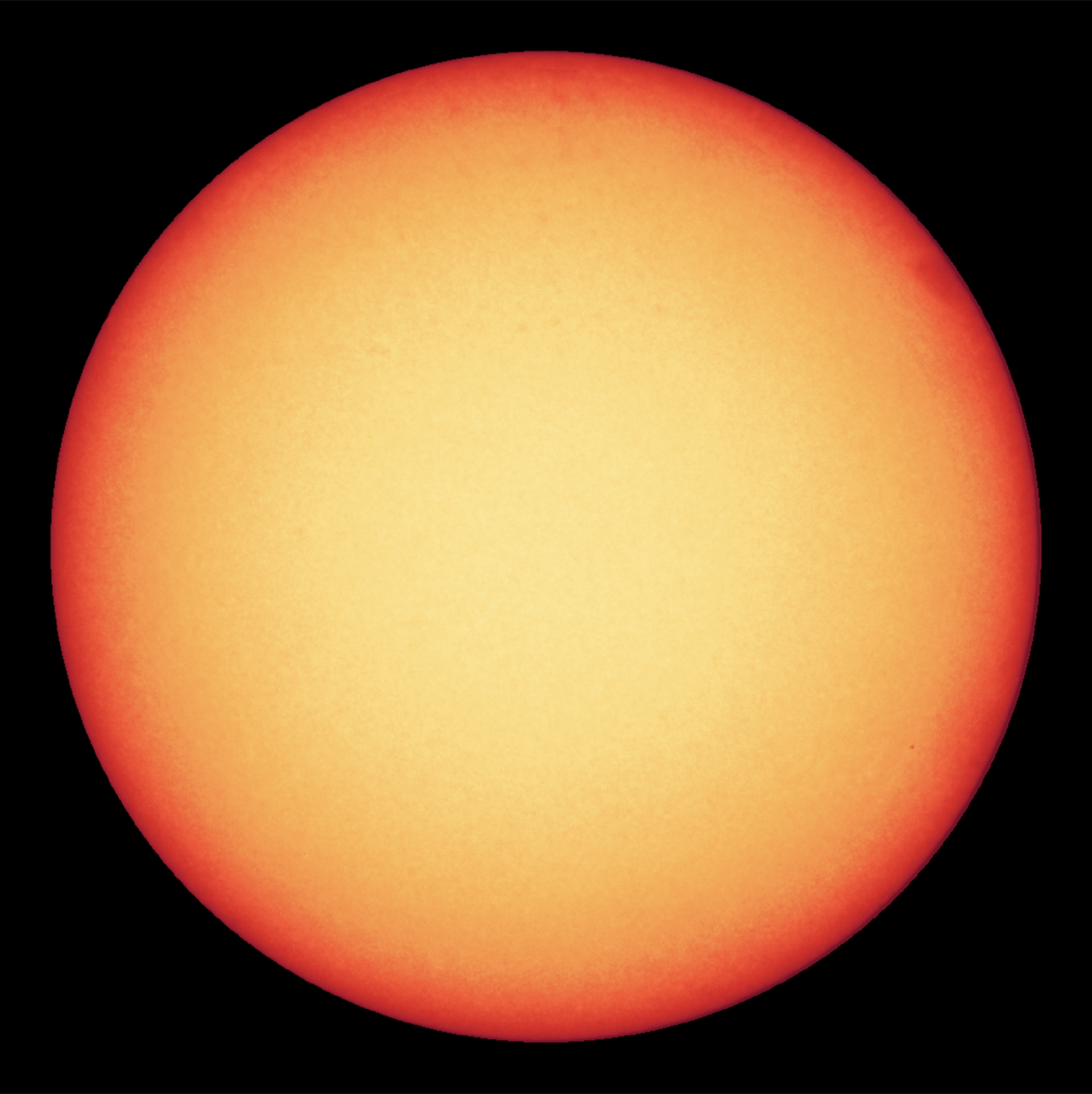

## Zmień shader słońca na bardziej realistyczny.

|

||||

### Zadanie*

|

||||

|

||||

Na poniższym obrazku jest zdjęcie słońca. Jest ono ciemniejsze na brzegach spróbuj uzyskać podobny efekt. Przydadzą się wektory z poprzednich punktów jak wektor normalny i wektor **V**.

|

||||

|

||||

|

||||

196

grk/cw 6/Zadania 7.html

Normal file

@ -0,0 +1,196 @@

|

||||

<!DOCTYPE html>

|

||||

<html xmlns="http://www.w3.org/1999/xhtml" lang="" xml:lang="">

|

||||

<head>

|

||||

<meta charset="utf-8" />

|

||||

<meta name="generator" content="pandoc" />

|

||||

<meta name="viewport" content="width=device-width, initial-scale=1.0, user-scalable=yes" />

|

||||

<title>Zadania 7</title>

|

||||

<style>

|

||||

code{white-space: pre-wrap;}

|

||||

span.smallcaps{font-variant: small-caps;}

|

||||

span.underline{text-decoration: underline;}

|

||||

div.column{display: inline-block; vertical-align: top; width: 50%;}

|

||||

div.hanging-indent{margin-left: 1.5em; text-indent: -1.5em;}

|

||||

ul.task-list{list-style: none;}

|

||||

pre > code.sourceCode { white-space: pre; position: relative; }

|

||||

pre > code.sourceCode > span { display: inline-block; line-height: 1.25; }

|

||||

pre > code.sourceCode > span:empty { height: 1.2em; }

|

||||

code.sourceCode > span { color: inherit; text-decoration: inherit; }

|

||||

div.sourceCode { margin: 1em 0; }

|

||||

pre.sourceCode { margin: 0; }

|

||||

@media screen {

|

||||

div.sourceCode { overflow: auto; }

|

||||

}

|

||||

@media print {

|

||||

pre > code.sourceCode { white-space: pre-wrap; }

|

||||

pre > code.sourceCode > span { text-indent: -5em; padding-left: 5em; }

|

||||

}

|

||||

pre.numberSource code

|

||||

{ counter-reset: source-line 0; }

|

||||

pre.numberSource code > span

|

||||

{ position: relative; left: -4em; counter-increment: source-line; }

|

||||

pre.numberSource code > span > a:first-child::before

|

||||

{ content: counter(source-line);

|

||||

position: relative; left: -1em; text-align: right; vertical-align: baseline;

|

||||

border: none; display: inline-block;

|

||||

-webkit-touch-callout: none; -webkit-user-select: none;

|

||||

-khtml-user-select: none; -moz-user-select: none;

|

||||

-ms-user-select: none; user-select: none;

|

||||

padding: 0 4px; width: 4em;

|

||||

color: #aaaaaa;

|

||||

}

|

||||

pre.numberSource { margin-left: 3em; border-left: 1px solid #aaaaaa; padding-left: 4px; }

|

||||

div.sourceCode

|

||||

{ }

|

||||

@media screen {

|

||||

pre > code.sourceCode > span > a:first-child::before { text-decoration: underline; }

|

||||

}

|

||||

code span.al { color: #ff0000; font-weight: bold; } /* Alert */

|

||||

code span.an { color: #60a0b0; font-weight: bold; font-style: italic; } /* Annotation */

|

||||

code span.at { color: #7d9029; } /* Attribute */

|

||||

code span.bn { color: #40a070; } /* BaseN */

|

||||

code span.bu { } /* BuiltIn */

|

||||

code span.cf { color: #007020; font-weight: bold; } /* ControlFlow */

|

||||

code span.ch { color: #4070a0; } /* Char */

|

||||

code span.cn { color: #880000; } /* Constant */

|

||||

code span.co { color: #60a0b0; font-style: italic; } /* Comment */

|

||||

code span.cv { color: #60a0b0; font-weight: bold; font-style: italic; } /* CommentVar */

|

||||

code span.do { color: #ba2121; font-style: italic; } /* Documentation */

|

||||

code span.dt { color: #902000; } /* DataType */

|

||||

code span.dv { color: #40a070; } /* DecVal */

|

||||

code span.er { color: #ff0000; font-weight: bold; } /* Error */

|

||||

code span.ex { } /* Extension */

|

||||

code span.fl { color: #40a070; } /* Float */

|

||||

code span.fu { color: #06287e; } /* Function */

|

||||

code span.im { } /* Import */

|

||||

code span.in { color: #60a0b0; font-weight: bold; font-style: italic; } /* Information */

|

||||

code span.kw { color: #007020; font-weight: bold; } /* Keyword */

|

||||

code span.op { color: #666666; } /* Operator */

|

||||

code span.ot { color: #007020; } /* Other */

|

||||

code span.pp { color: #bc7a00; } /* Preprocessor */

|

||||

code span.sc { color: #4070a0; } /* SpecialChar */

|

||||

code span.ss { color: #bb6688; } /* SpecialString */

|

||||

code span.st { color: #4070a0; } /* String */

|

||||

code span.va { color: #19177c; } /* Variable */

|

||||

code span.vs { color: #4070a0; } /* VerbatimString */

|

||||

code span.wa { color: #60a0b0; font-weight: bold; font-style: italic; } /* Warning */

|

||||

</style>

|

||||

<link rel="stylesheet" href="style.css" />

|

||||

<script src="https://cdn.jsdelivr.net/npm/mathjax@3/es5/tex-chtml-full.js" type="text/javascript"></script>

|

||||

<!--[if lt IE 9]>

|

||||

<script src="//cdnjs.cloudflare.com/ajax/libs/html5shiv/3.7.3/html5shiv-printshiv.min.js"></script>

|

||||

<![endif]-->

|

||||

</head>

|

||||

<body>

|

||||

<h1 id="normal-mapping">Normal Mapping</h1>

|

||||

<p>W tej części będziemy dalej modyfikować shadery <strong>shader_5_tex</strong> poprzez implementację normal mappingu.</p>

|

||||

<p>Obliczenia dla map normalnych należy wykonywać w przestrzeni stycznych. Przestrzeń styczna jest wyliczana dla każdego punktu w obiekcie. Jej celem jest takie przekształcenie przestrzeni, żeby wektor normalny był wektorem jednostkowym (0,1,0).</p>

|

||||

<p>Do wyliczenia przestrzeni stycznej potrzebujemy dla każdego wierzchołka oprócz wektora normalnego wektor styczny i bistyczny (<em>tangent</em> i <em>bitangent</em>). Są one wyliczane przez bibliotekę <code>Assimp</code>.</p>

|

||||

<h3 id="wykonaj-kopię-shaderów-shader_4_tex.vert-shader_4_tex.frag">Wykonaj kopię shaderów shader_5_tex.vert shader_5_tex.frag</h3>

|

||||

<h3 id="przenieś-obliczenia-światła-do-przestrzeni-stycznej.">Przenieś obliczenia światła do przestrzeni stycznej.</h3>

|

||||

<ol type="1">

|

||||

<li><p>Oblicz macierz <strong>TBN</strong>.</p>

|

||||

<p>Macierz <strong>TBN</strong> to macierz 3x3 wyznaczana przez wektory <em>tangent</em>, <em>bitangent</em> i <em>normal</em>, służy do przenoszenia wektorów z przestrzeni świata do przestrzeni stycznej.</p>

|

||||

<ol type="1">

|

||||

<li>W <strong>vertex shaderze</strong> przekrztałć wektory <code>vertexNormal</code>, <code>vertexTangent</code> i <code>vertexBitangent</code> do przestrzeni świata (przemnóż macierz modelu przez te wektory, tak jak to robiliśmy wcześniej z wektorem normalnym, z uwzględnieniem zmiennej w=0) i zapisz wyniki odpowiednio w zmiennych <code>normal</code>, <code>tangent</code> i <code>bitangent</code>.

|

||||

<ol type="1">

|

||||

<li>Stwórz macierz 3x3 TBN jako transpose(mat3(tangent, bitangent, normal)). Macierz transponujemy, aby szybko uzyskać jej odwrotność (możemy tak zrobić przy założeniu, ze jest ortogonalna).</li>

|

||||

</ol></li>

|

||||

</ol></li>

|

||||

</ol>

|

||||

<ol start="2" type="1">

|

||||

<li>Przenieś wektor światła i wektor widoku do przestrzeni stycznych

|

||||

<ol type="1">

|

||||

<li><p>Musimy przekształcić wektor światła (L) i wektor widoku (V) do przestrzeni stycznych. Zrobimy to w vertex shaderze. W tym celu przenieś potrzebne dane dotyczące światła i kamery (uniformy <code>lightPos</code> i <code>cameraPos</code>) z <strong>fragment shadera</strong> do <strong>vertex shadera.</strong></p></li>

|

||||

<li><p>Oblicz wektor <code>viewDir</code> jako znormalizowana różnice <code>cameraPos</code> i <code>worldPos</code> (tu jeszcze działamy w przestrzeni świata). Analogicznie oblicz <code>lightDir</code> jako różnicę <code>lightPos</code> i <code>worldPos</code></p></li>

|

||||

<li><p>Przekształć wektory <code>viewDir</code> i <code>lightDir</code> do przestrzeni stycznej mnożąc je przez macierz <strong>TBN</strong>. Wynik zapisz w zmiennych <code>viewDirTS</code> i <code>lightDirTS</code> odpowiednio.</p></li>

|

||||

<li><p>Przekaż <code>viewDirTS</code> i <code>lightDirTS</code> do fragment shadera. (zadeklaruj je jako zmienne <code>out</code>)</p>

|

||||

<blockquote>

|

||||

<p>(Sufiks TS oznacza tangent space. Ważne jest, aby oznaczać (np. dopisując coś do nazwy zmiennej) w jakiej przestrzeni znajdują się używane wektory, tak aby poprawnie wykonywać obliczenia. Trzeba zawsze zwracać uwagę na to, w jakiej przestrzeni działamy.)</p>

|

||||

</blockquote></li>

|

||||

</ol></li>

|

||||

<li>Przekształć <strong>fragment shader</strong>, by obsługiwał <strong>tangent space</strong>

|

||||

<ol type="1">

|

||||

<li>Nie potrzebujemy już we <strong>fragment shaderze</strong> informacji na temat pozycji fragmentu i wektora normalnego geometrii, skasuj wiec zmienne przekazujące te wektory pomiędzy shaderami.</li>

|

||||

<li>wektora <code>lightDir</code> powinniśmy użyć wektora <code>lightDirTS</code> (należy go dodatkowo znormalizować), a jako wektor widoku V powinniśmy użyć wektora <code>viewDirTS</code> (również należy go znormalizować). Jako wektora N użyj na razie wektora vec3(0,0,1).</li>

|

||||

</ol></li>

|

||||

</ol>

|

||||

<p>Efekt finalny powinien wyglądać tak samo, jak przed jakąkolwiek zmianą. Następnym krokiem będzie wykorzystanie map normalnych.</p>

|

||||

<h3 id="wykorzystaj-normalmapy">Wykorzystaj normalmapy</h3>

|

||||

<ol type="1">

|

||||

<li>Chcemy wczytywać normalne z tekstury, w tym celu dodaj we <strong>fragment shaderze</strong> dodatkowy sampler do czytania map normalnych, nazwij go <code>normalSampler</code>. Pobierz z niego wektor normalny analogicznie, jak czytamy kolor zwykłej tekstury z samplera <code>textureSampler</code> i zapisz go w zmiennej <code>N</code>.

|

||||

<ol start="2" type="1">

|

||||

<li>Ponieważ w teksturze wartości są w przedziale <span class="math inline">\([0,1]\)</span>, musimy jeszcze przekształcić je do przedziału <span class="math inline">\([-1,1]\)</span>. W tym celu przemnóż wektor N przez 2 i odejmij 1. Na koniec warto jeszcze znormalizować wektor normalny, aby uniknąć błędów związanych z precyzja lub kompresja tekstury.</li>

|

||||

<li>Wczytaj pliki zawierające mapy normalnych w kodzie C++ W tym celu załaduj przy użyciu funkcji <code>Core::LoadTexture</code> mapy normalnych dla wszystkich modeli. Maja one taką samą nazwę jak zwykle tekstury, tyle że z suffiksem "_normals".</li>

|

||||